超详细!Stable Diffusion 真人照片转动漫风格保姆级教程

扫一扫

扫一扫

扫一扫

扫一扫

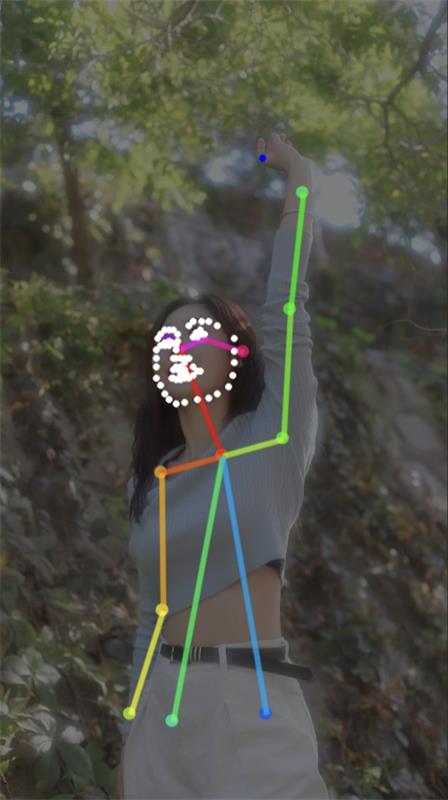

相信我们很多人在看过动漫/动画后,都想看一看二次元世界中的自己长什么样子,那今天就以客户照片为例,说说我们如何用 Stable Diffusion,让 AI 帮我们将真实照片转成一个绝美二次元少女,Let’s do it~ 更多SD干货: 大厂出品!如何用 ControlNet 实现精准的画面色彩控制?颜色控制一直是 AIGC 的难点,prompt 会污染、img2img 太随机… 阅读文章 >客户原图照片如下,希望转成二次元甜美少女。

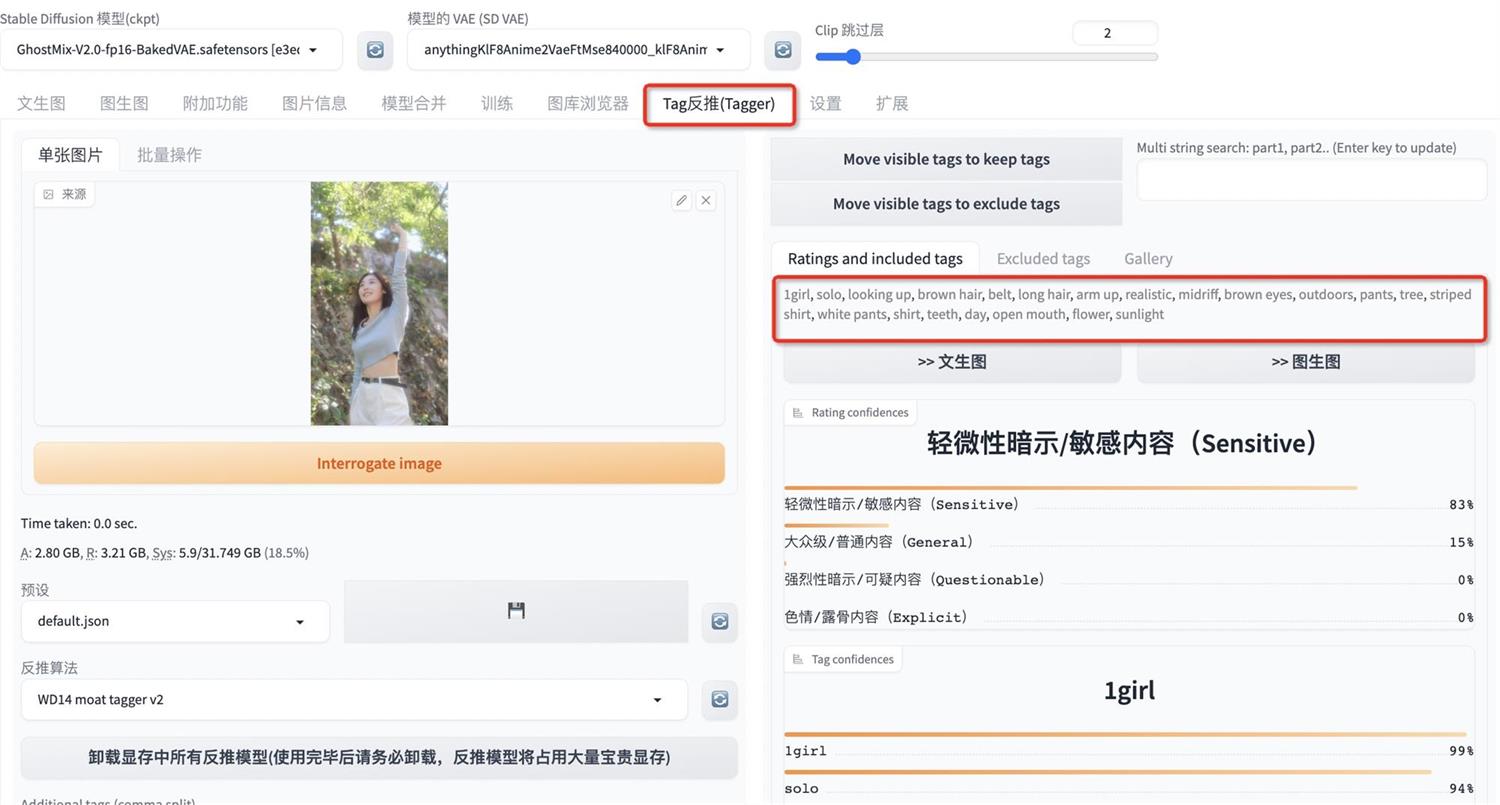

1. 打开 Web UI ,用 Tag 反推,辅助书写关键词

用 Tag 反推中传入照片,点击反推得到红框中大致的画面内容描述词

调整权重顺序,结合 Sd 通用画质关键词,添加我们想要的内容,得到以下正向关键词

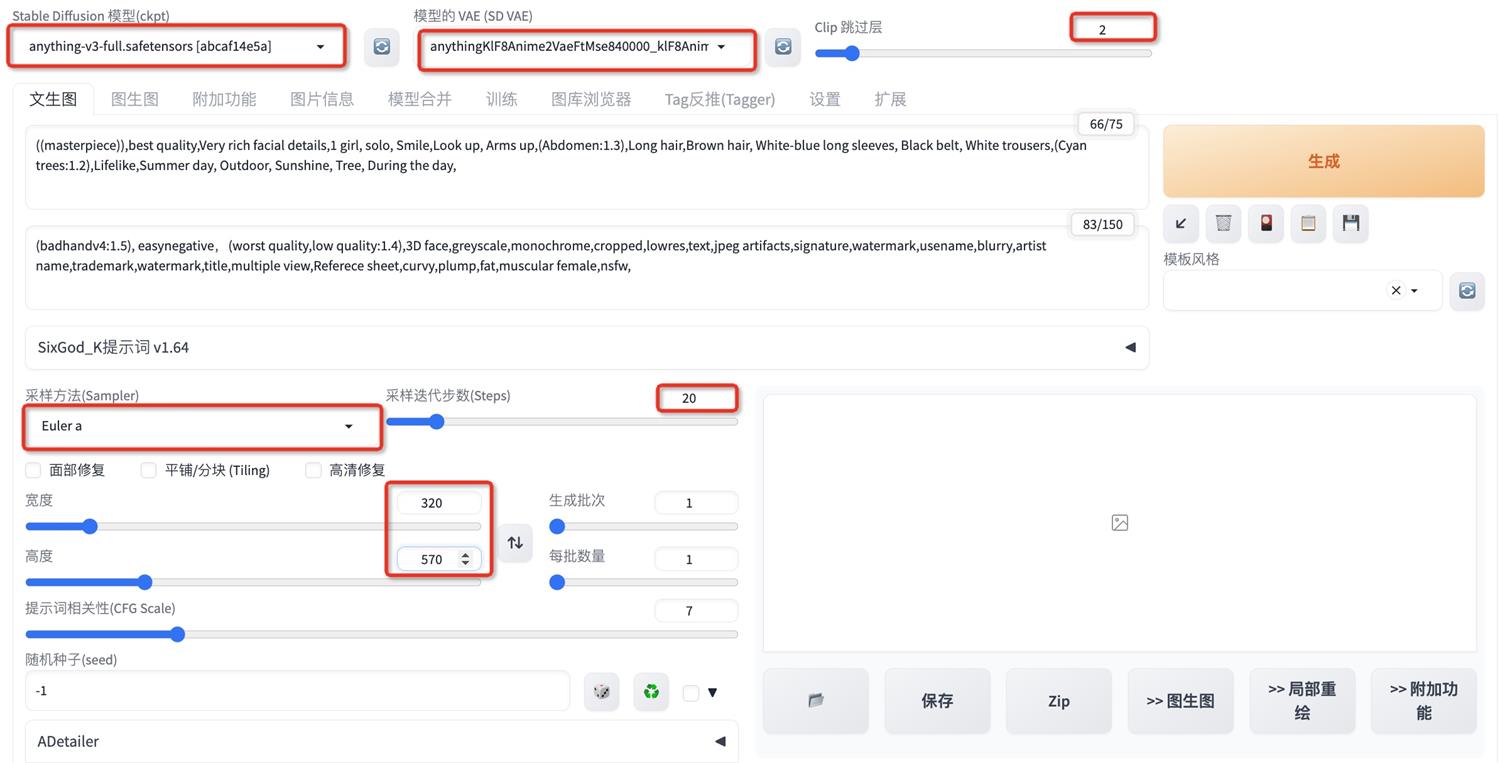

负面提示词输入通用模板,将 2 个处理手的 embedding badhand 和 easynegative 放在最前面,并给(badhand:1.5)增加 1.5 的权重,得到以下 (badhandv4:1.5), easynegative,(worst quality,low quality:1.4),3D face,greyscale,monochrome,cropped,lowres,text,jpeg artifacts,signature,watermark,usename,blurry,artist name,trademark,watermark,title,multiple view,Referece sheet,curvy,plump,fat,muscular female,nsfw, 2. 选择模型,测试关键词 我的 web ui 中二次元画风模型有十几个,我们先随意选择 1 个 anything 模型来测试关键词,配合 anything 的 vAE,clip 跳过层设置 2,重要设置如下所示

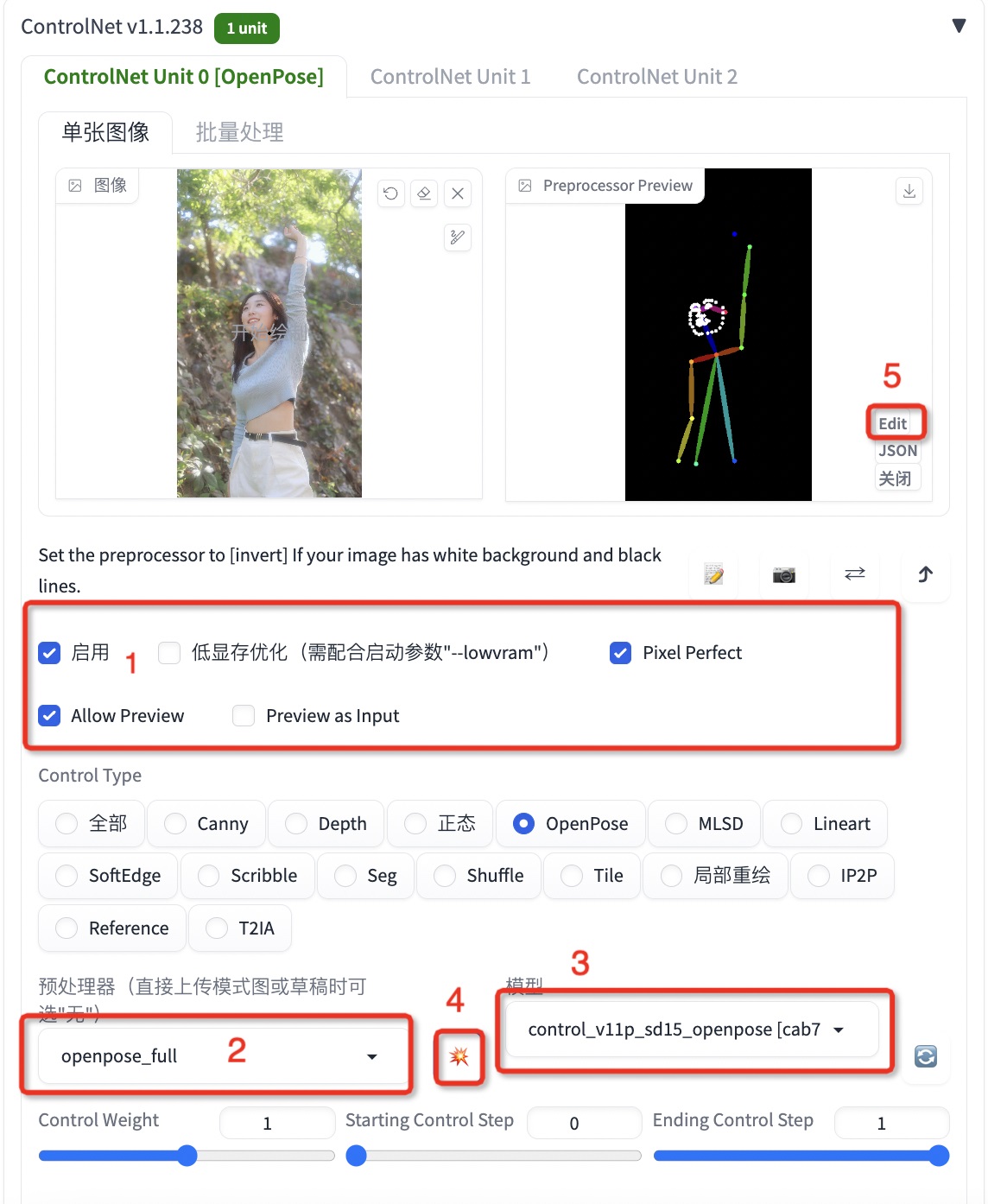

3. 使用 Controlnet 的 openpose full 处理器与模型,检测全身骨骼来控制姿势 重要设置如下图所示,完成设置后,点击 4 爆炸小按钮,得到右边黑色骨骼图:

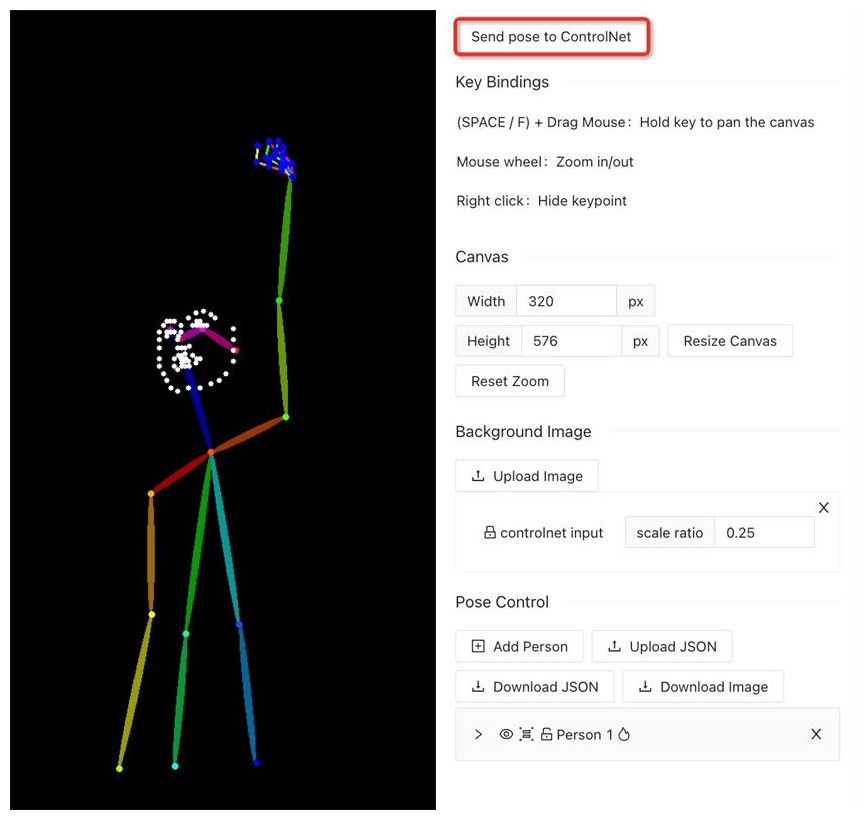

点击步骤 5 能看骨骼图与人物的对应情况,我们能发现 openpose 处理后的骨骼不准确,腿部骨骼缺失,右手手指没有骨骼 使用 openpose 的骨骼编辑插件,重新添加骨骼,得到新骨骼如下,然后 send pose to controlnet 发送骨骼到 controlnet

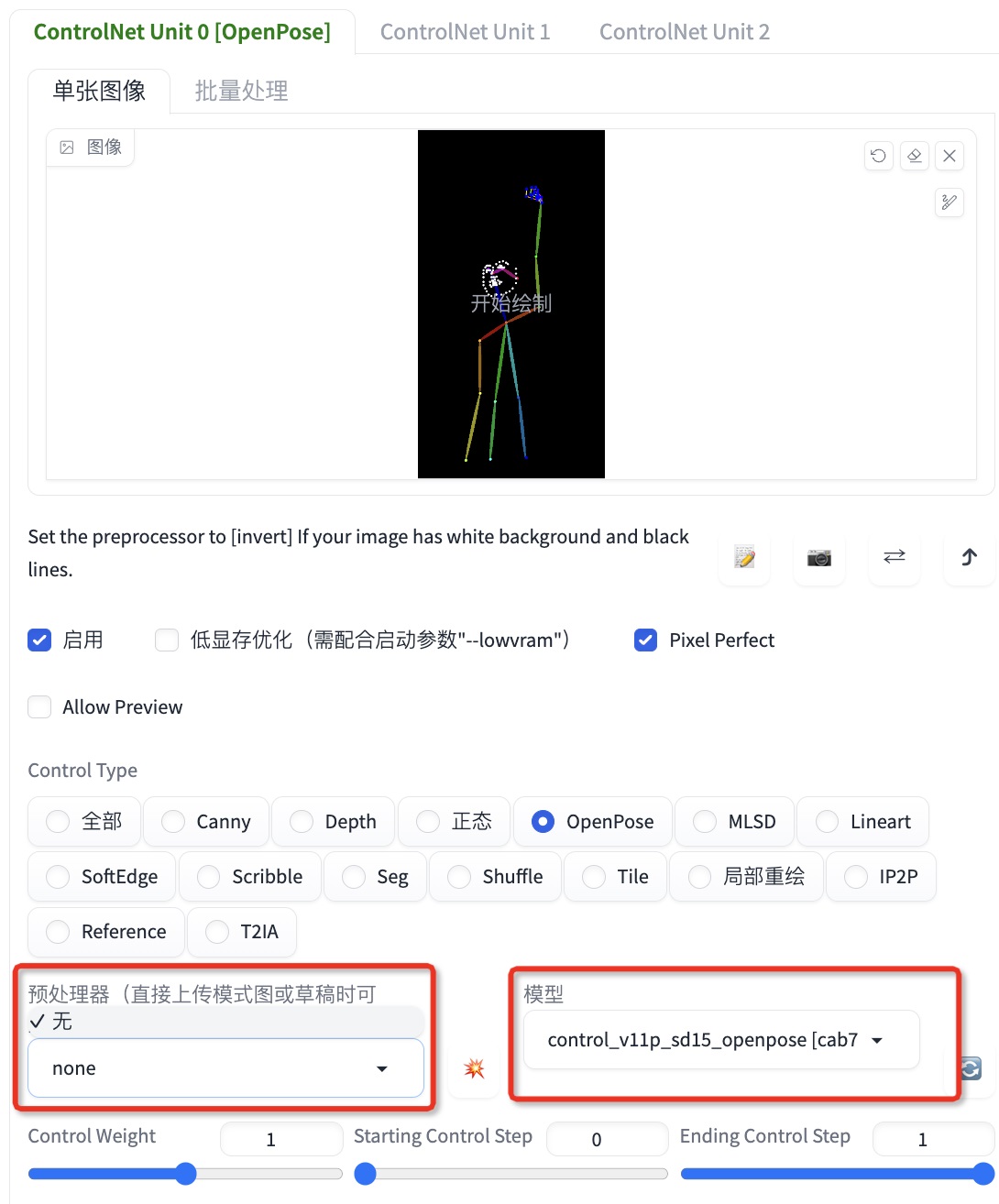

注:openpose 的骨骼编辑插件使用教程有一点复杂,可以在 B 站看一个教程后再开始操作 4. 得到新骨骼后,第一个 controlnet 预处理器选择“无”,模型选择 open pose

5. 第二个 controlnet 预处理器选择 SoftEdge_pidnet,模型选择 SoftEdge,设置如下所示 SoftEdge 模型的作用是软边缘检测,可以检测到原图边缘轮廓信息,得到处理结果如下图

6. 完成以上所有设置,点击「生成」进行第一次试跑,测试模型与 controlnet 的控制效果,结果如下

观察图片能够发现人物的姿势与外形轮廓控制还不错,但出现的问题是:

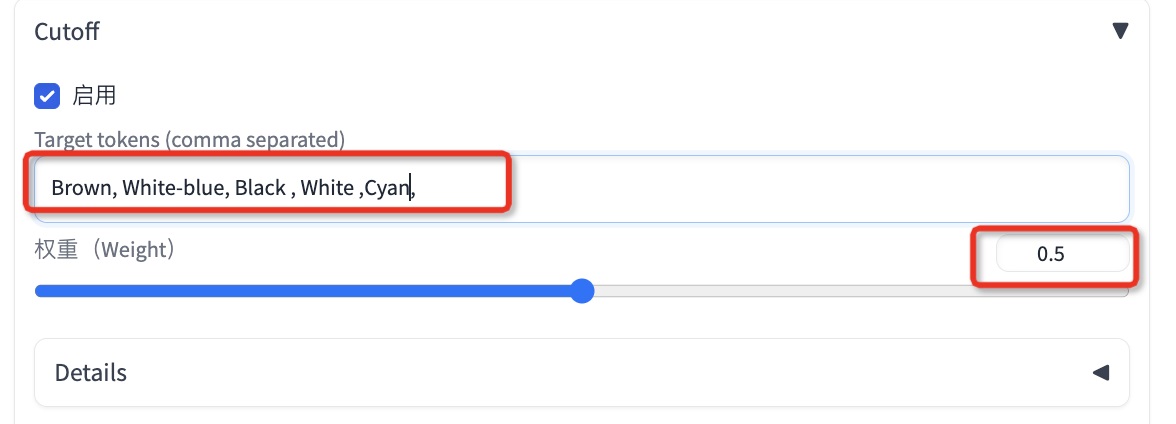

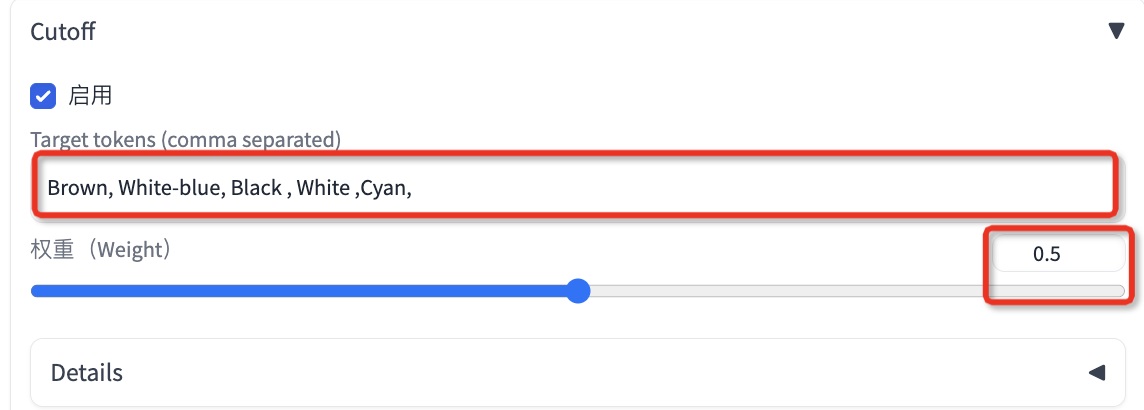

7. 首先解决颜色控制,可以使用 SD 颜色控制插件「cut off」 复制带颜色的关键词( Brown hair, White-blue long sleeves, Black belt, White trousers,(Cyan trees:1.2),)去掉后缀名词只保留颜色,得到以下颜色关键词

再次「生成」跑图测试,得到以下结果

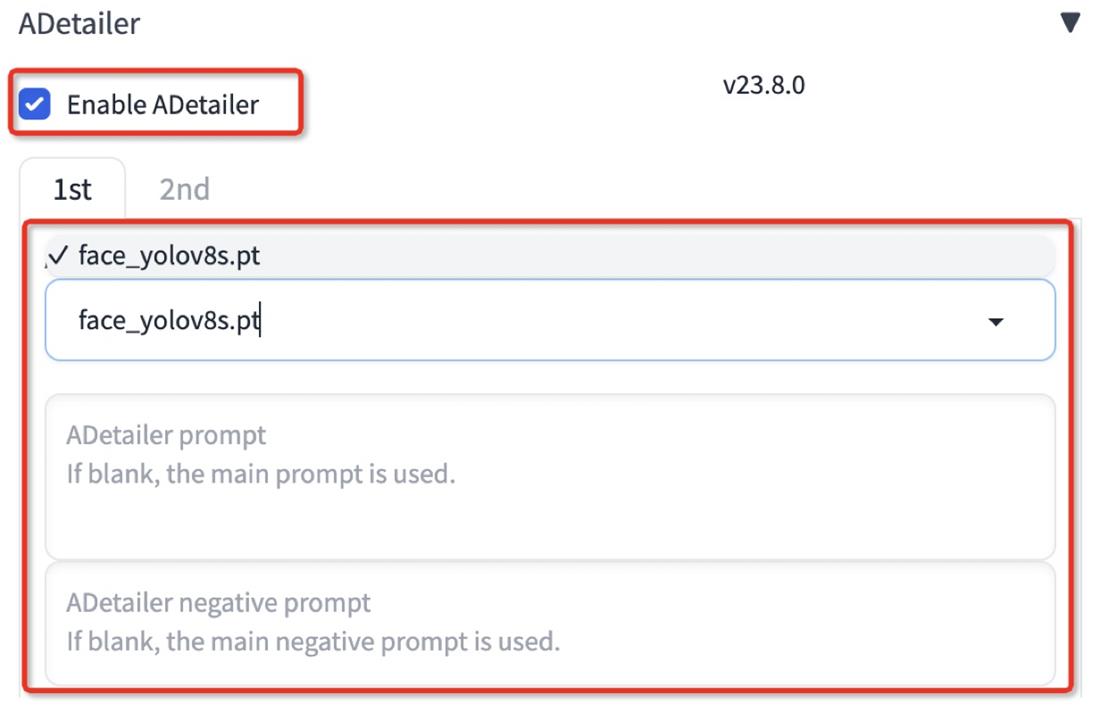

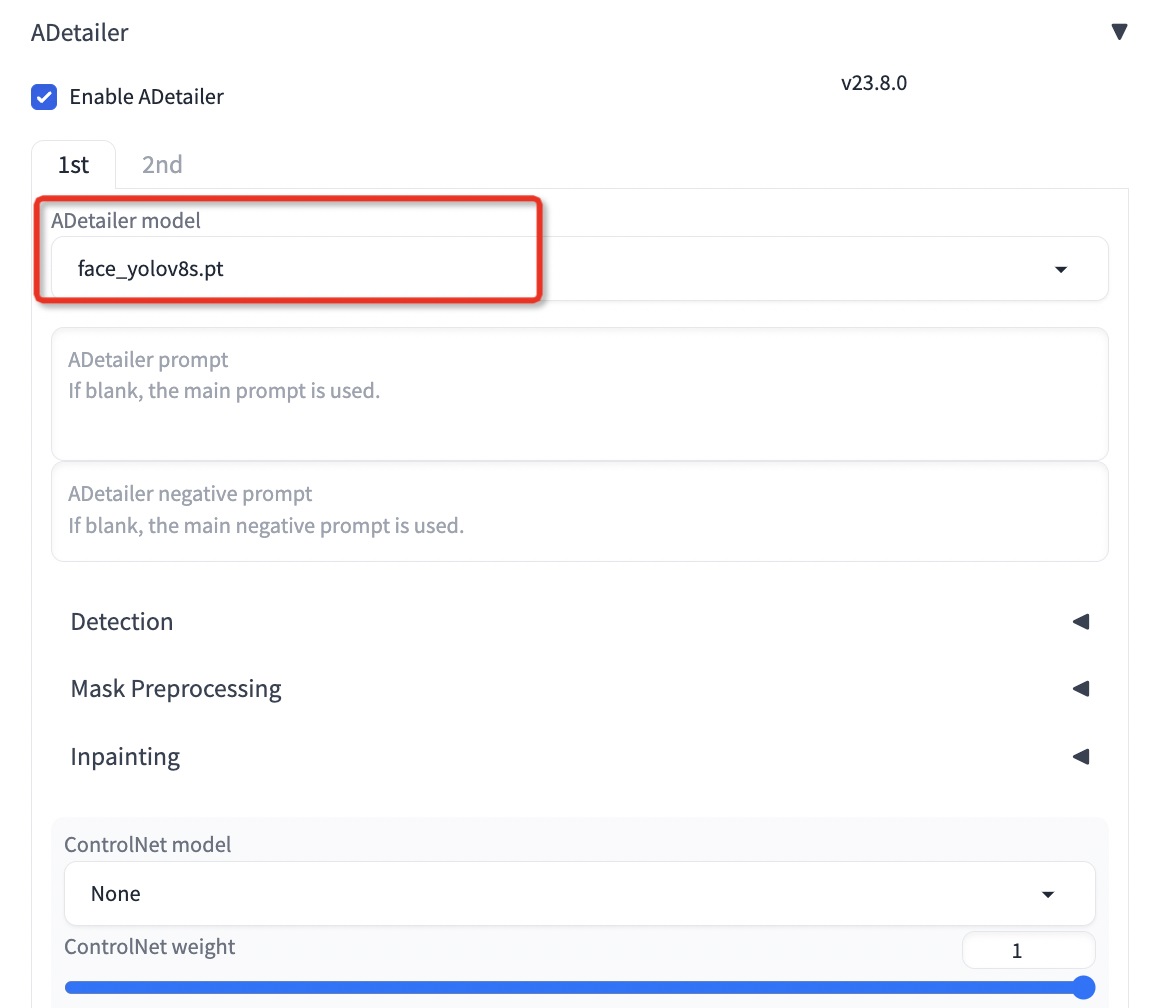

能够看到加入「cut off」效果还不错,第 2 张的颜色大部分是准确的,各颜色区别的很开 没有交错模糊;当然如果还不准确,可以适当提高红框权重到 1 进行测试 8. 接着解决面部崩坏的问题 使用 SD 的修脸插件「After Dtailer」缩写为「ADtailer」选择脸部模型「face_yolov8s.pt」正负关键词先不用写,保持空白

点击「生成」效果如下图所示

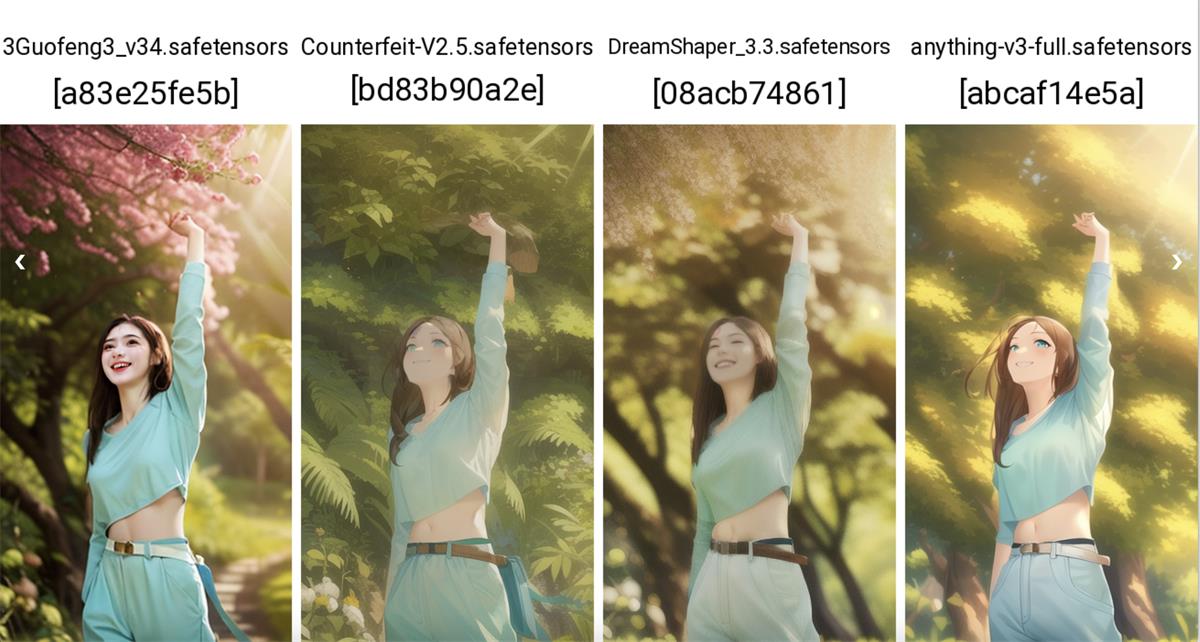

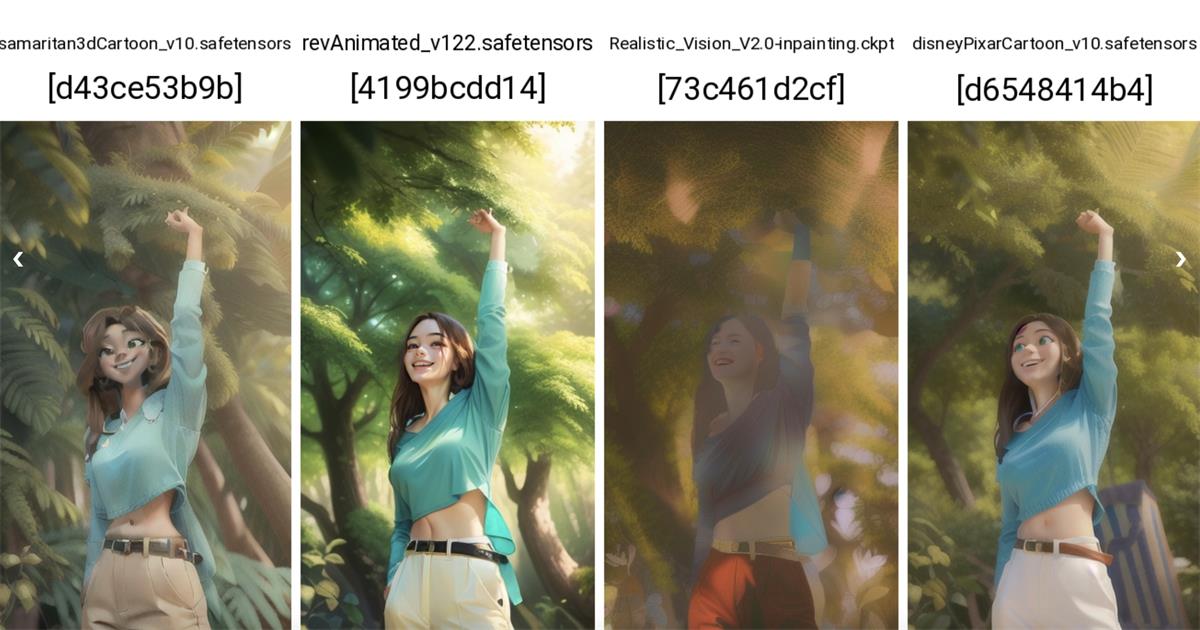

不得不说与前图对比,修脸效果非常棒,唯美二次元少女已经成型了一大半 9. 暂时先不解决手部问题,先测试模型,看是否有其他更仙,更好看的二次元大模型 前面说到我的 web ui 中二次元画风模型有十几个,为了提升效率,避免 1 个个去试,这里可以使用神器功能「脚本」进行测试 开启脚本,选择「x/y/z 图表」,X 轴选择我们想测试的参数—— 模型名「chechpoint name」 其他参数 Y、Z 轴先不动,将最下方的「宫格图边框」改为 10 ——可以让我们最终生成的每张宫格图 间距10像素

完成设置,点击「生成」跑图测试,我分了 3 次每组 4 个模型生成以下对比图,脚本的组合对比图真的超好用

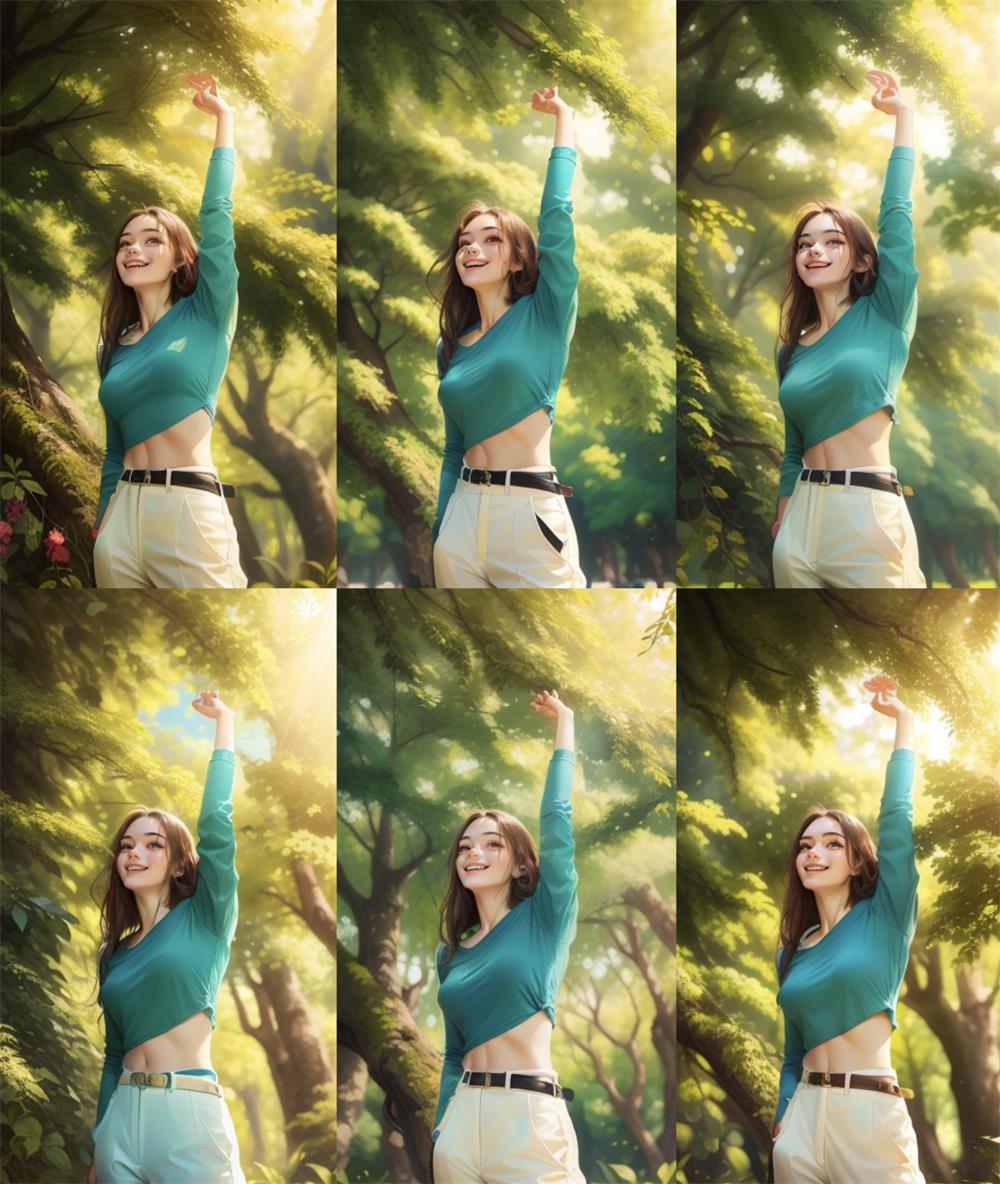

12 个模型对比,能看到目前最好看的是第三排第一个的「Ghost Mix _v2.0」模型,人物非常仙且脸部细节细腻,接下来就用「Ghost Mix _v2.0」模型进行优化 10. 选定模型,加大批次进行跑图筛选 选择「Ghost Mix _v2.0」模型,将「生成批次」调为 6,1 次跑 6 张,上面我们已经得到模型测试结果,就先将「脚本」功能关闭,点击「生成」

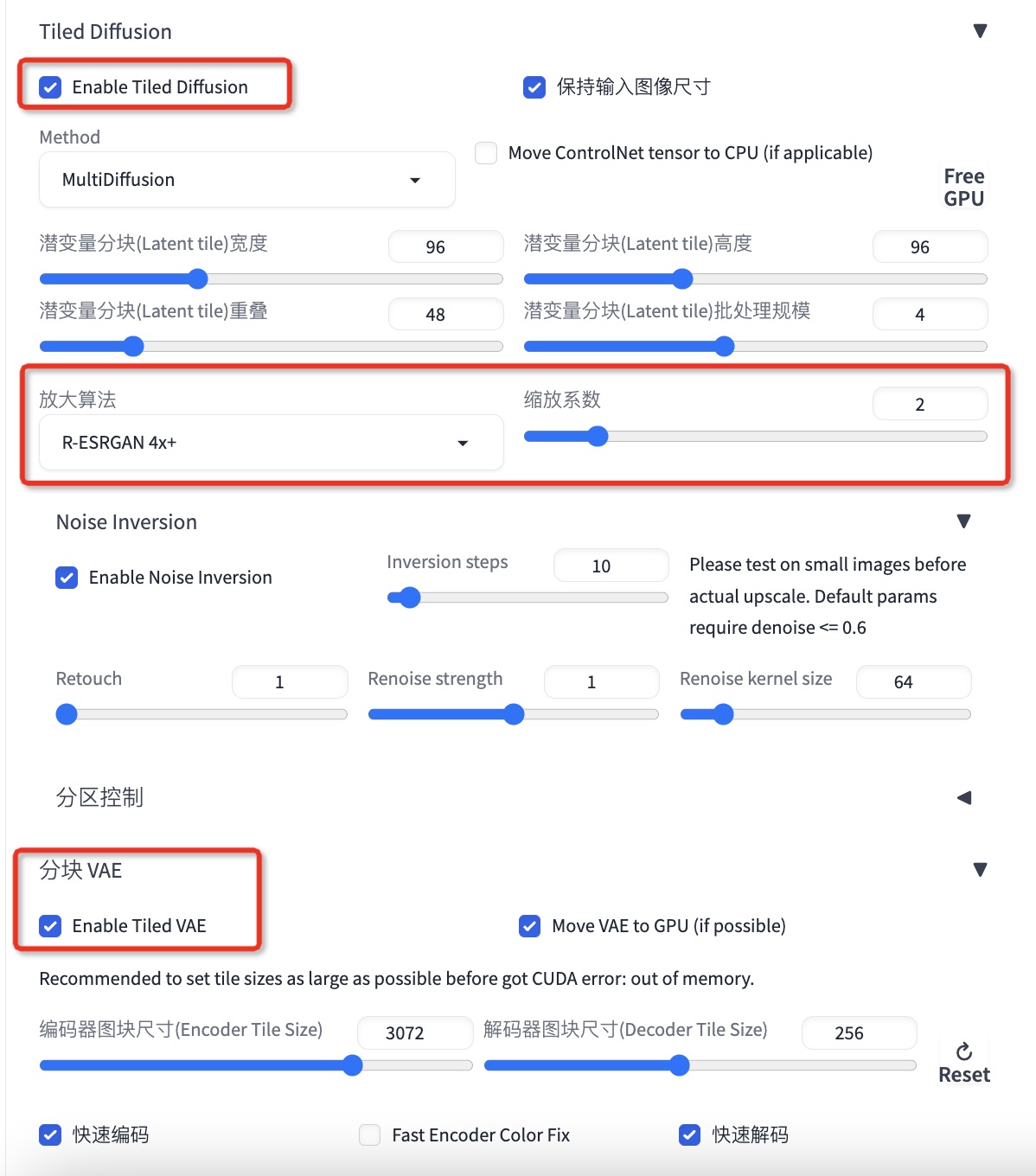

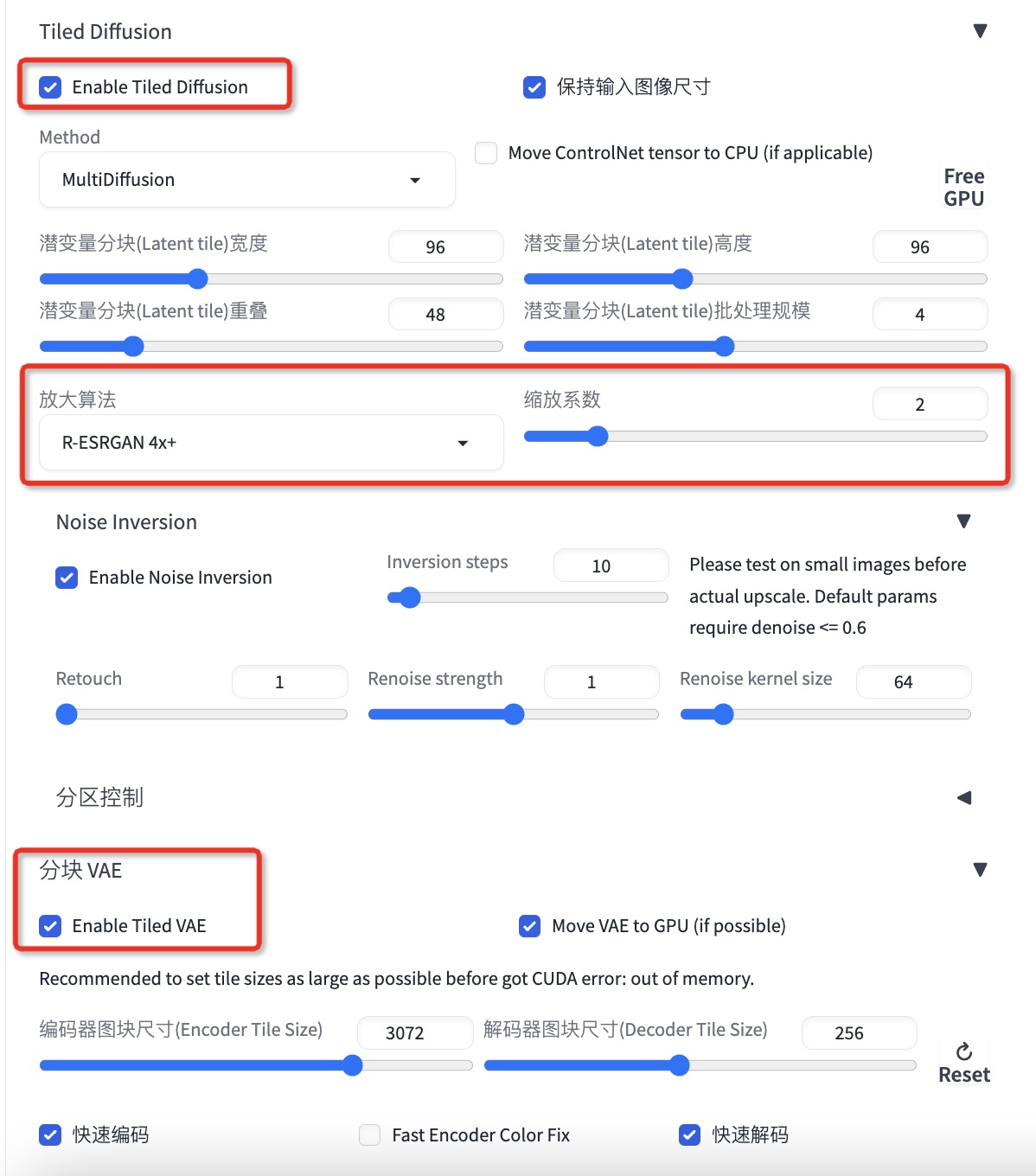

6 张中最后一张最好看,已经达到 60 分~~ 11、开启 SD 的修复步骤,将一张 60 分的图修复到 90 分 ①选择最后 1 张,将图发送到「图生图」开启图像高清修复放大的插件「Tiled Diffusion」「分块 VAE」,保持默认放大 2 倍,设置如下所示; 「Tiled Diffusion」插件功能:放大图片分辨率,高清修复图片

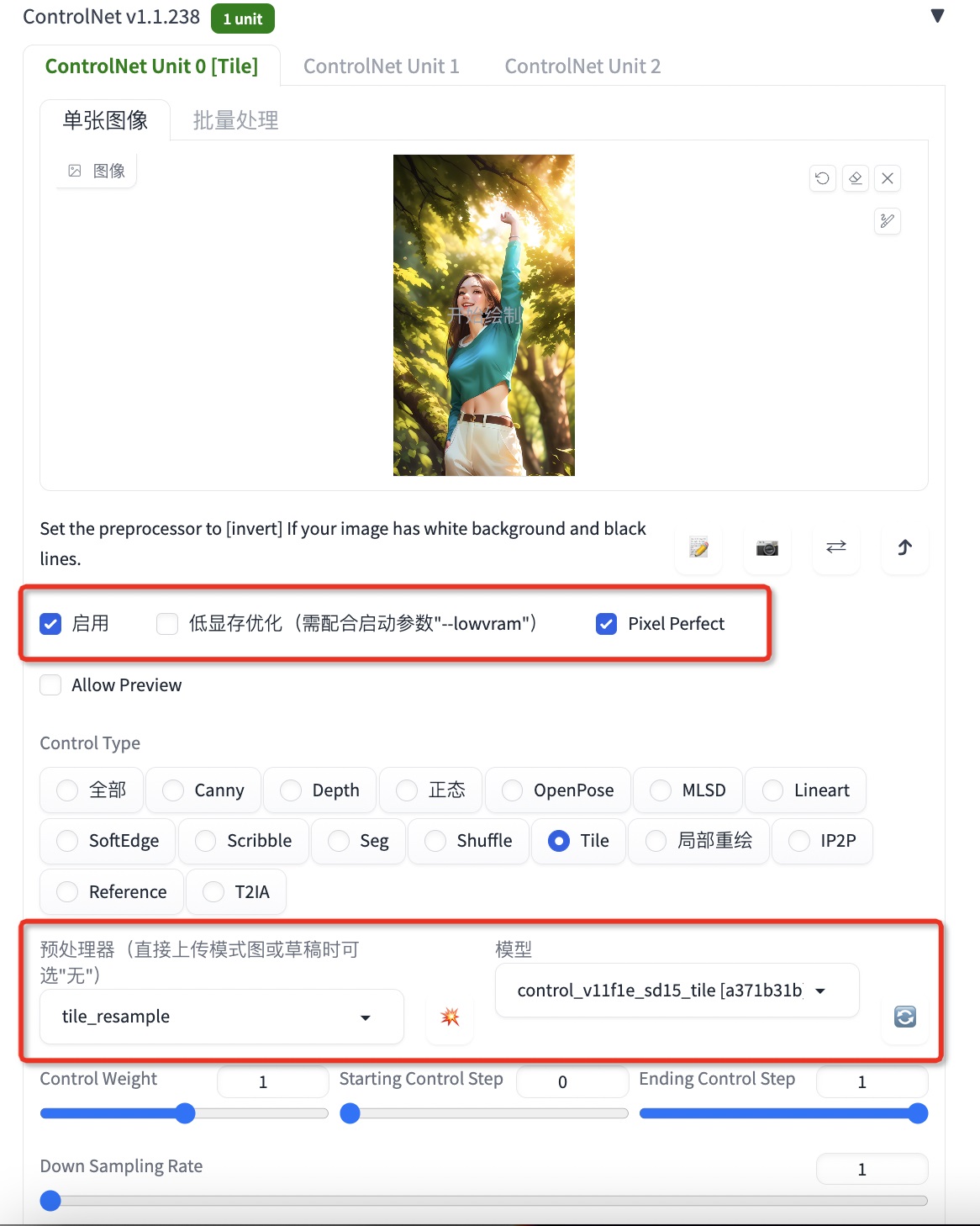

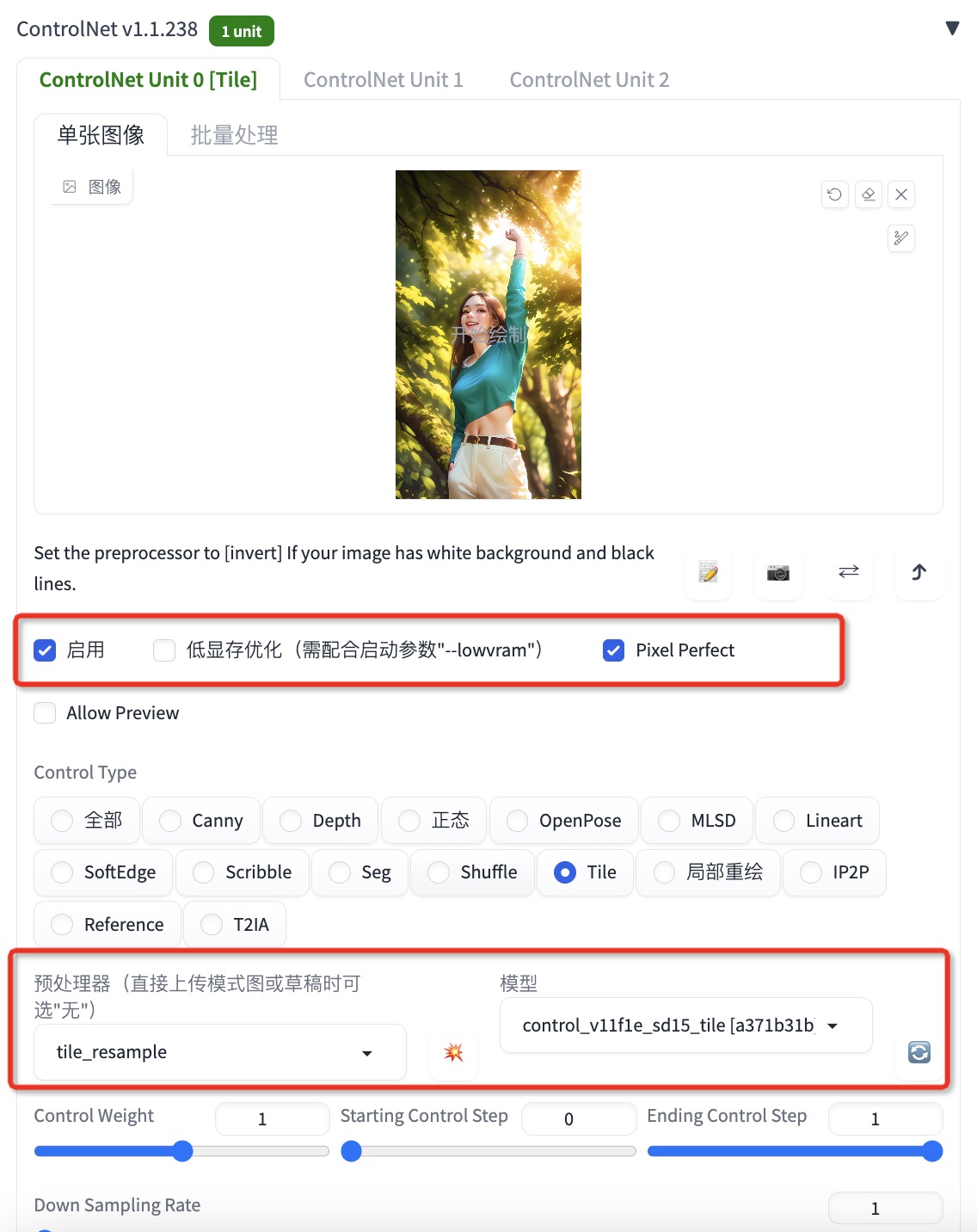

②开启 Controlnet, 选择「tile」模型与处理器,权重为 1.4,具体可根据测试效果调节 「tile」模型作用:与「Tiled Diffusion」配合使用,放大+修复+细节增强;

③开启「ADtailer」插件——作用:精准修脸插件,效果贼棒

④保持颜色控制插件「cut off」继续开启——作用:保持精准控制颜色分布

完成以上 4 步设置后,恭喜你可以开始点击「生成」去测试效果

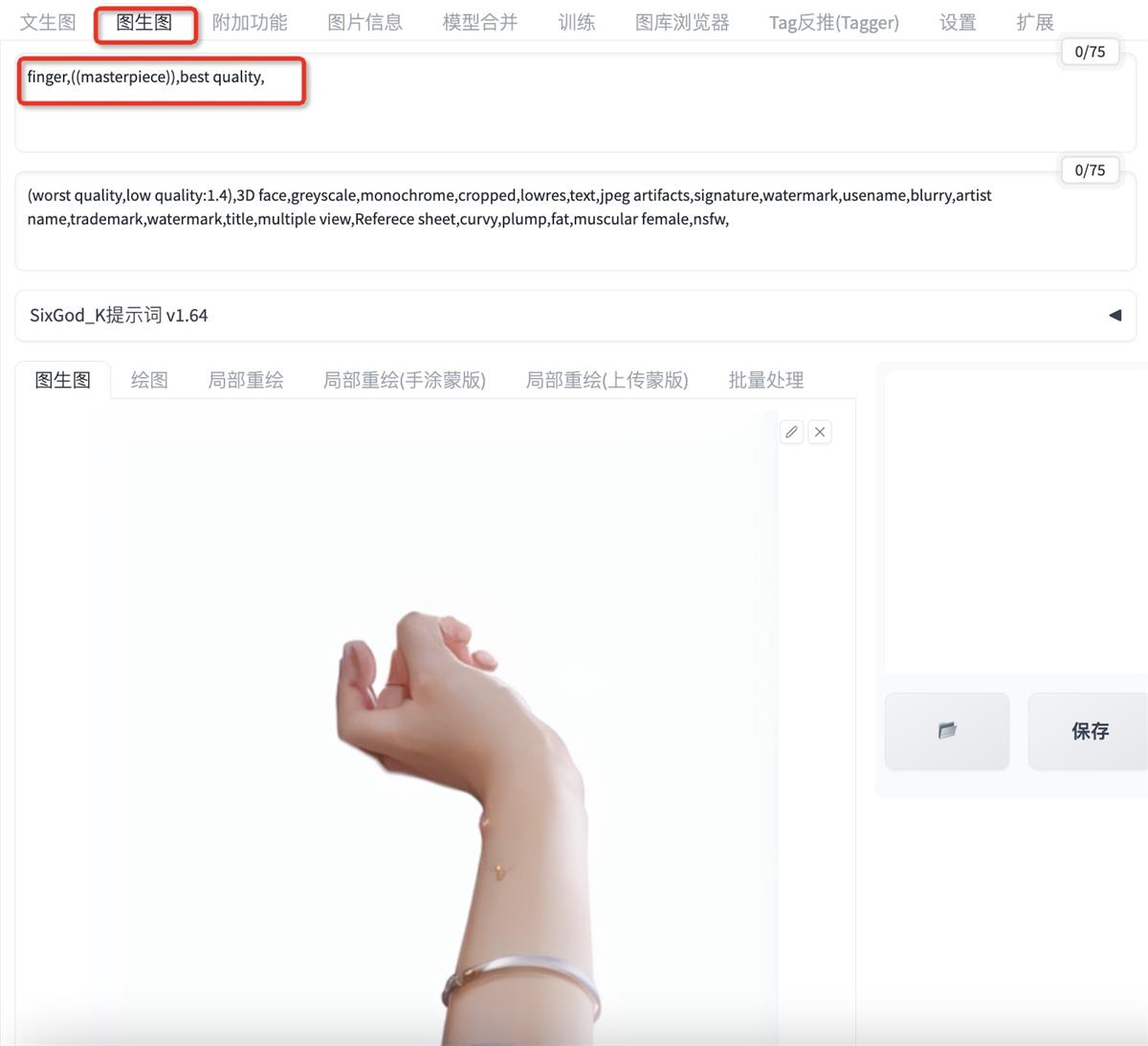

我的测试效果如图,功夫不负有心人,4 步修复后,除了右手的 bug,其他都非常美~ 12. 进入修手环节,PS 绘制大形,拖入给 SD 进行重绘 由于 SD 生手实在太费劲,我们需要给他更精准的参考,我的思路是直接把照片原图的手抠出来让 SD 重绘一下,再 P 到我们上面生成的美图上,这样就完成了一个精准的参考,真是个大聪明,说干就干 在 ps 中将照片原图的手抠出来,得到下图,能看到非常模糊,细节不够,不能直接使用,需要让 SD 重绘一下

①「图生图」重绘:保持模型不变,将抠出的手图拖入 SD 的「图生图」面板

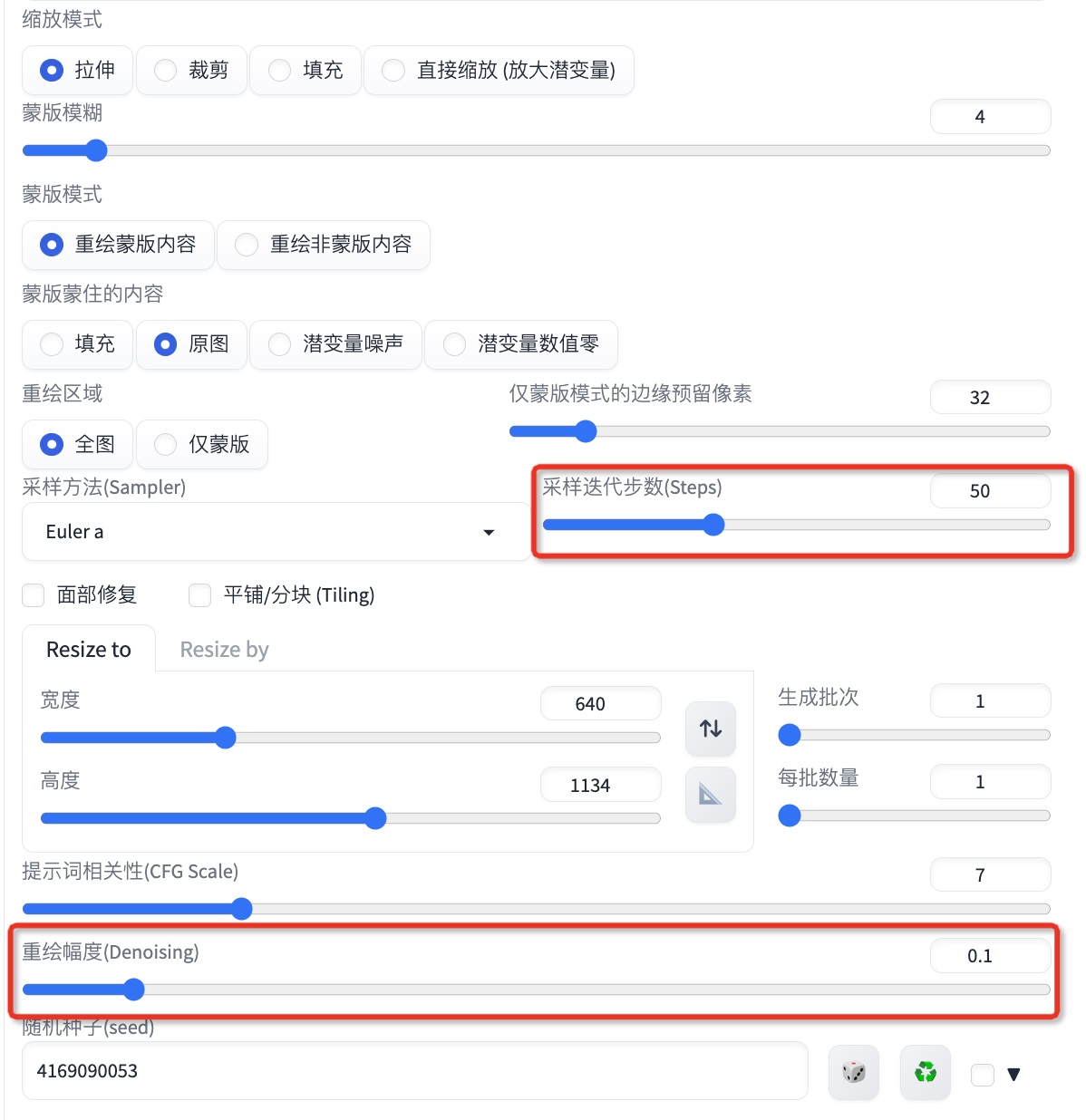

迭代步数设置为 50-128(增加细节),重绘幅度设置在 0.2 以下,具体可根据跑图效果微调,重绘幅度 0.2 以下非常重要 我们希望 SD 在参考上延续模型风格、微调细节,而不想让它改动太大,因此重绘幅度要小,太大将会自由发挥生成不是我们要的图,一般 0.1 就可以了;

②开启 controlnet「tile」预处理器与模型,放大 增加细节 设置完成后点击生成,得到下图左,用 ps 将这个手合在我们上面生成的图上,得到完整的图

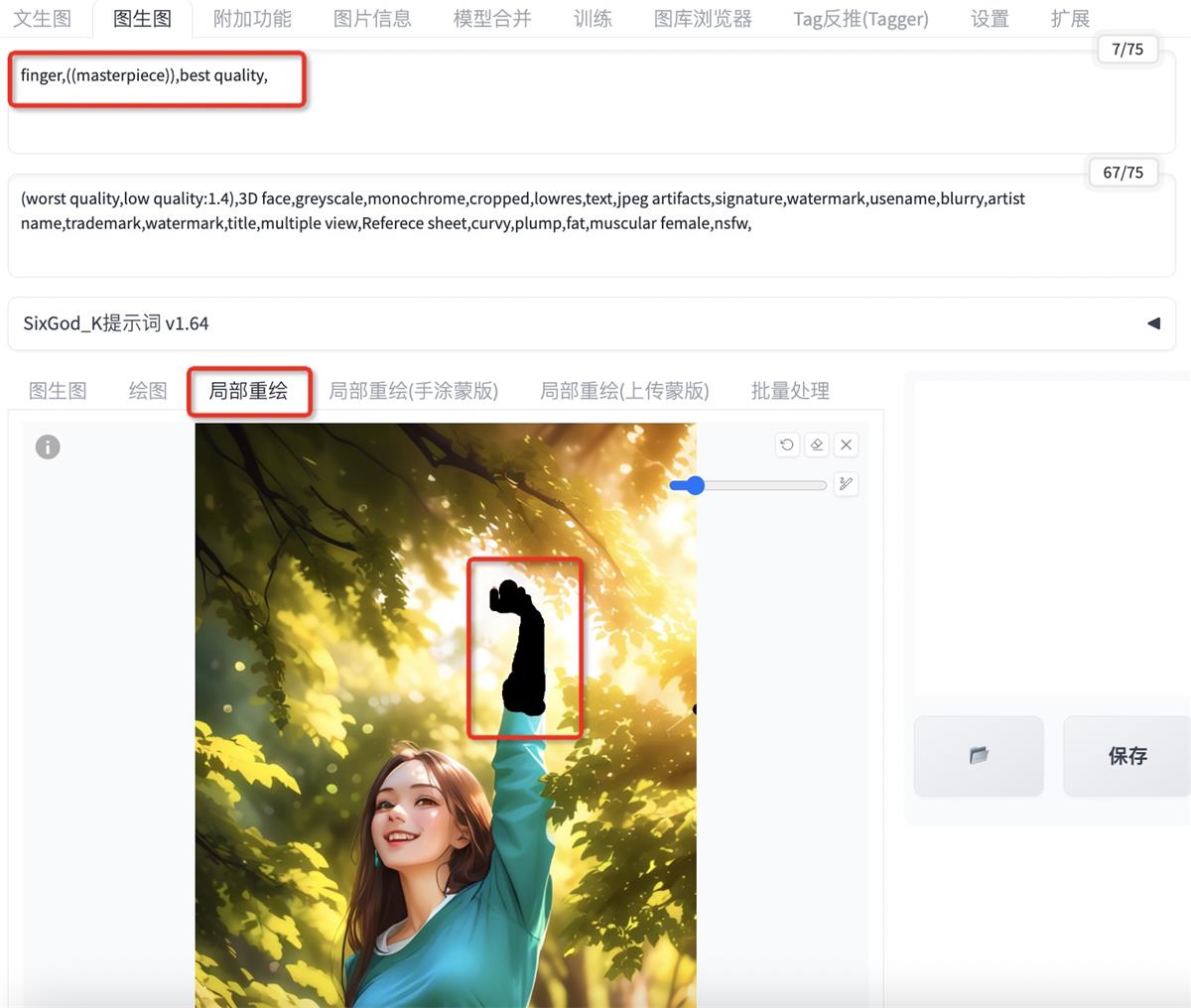

观察整图能看到问题:1 手的光影细节还是与环境不融合 2 人物面部细节不够; ③解决手的光影细节与环境不融合问题 将图片拖入到图生图的「局部重绘」,用蒙版将手部涂抹出来,「重绘幅度」开到 0.1(低重绘幅度,保持大体形象、骨骼、细节不变)

开启「tiled diffusion」「分块 VAE」以及 Controlnet「tile」预处理器与模型,重绘的同时提高图片分辨率,高清修复,加入丰富细节

完成以上设置,点击「生成」测试效果

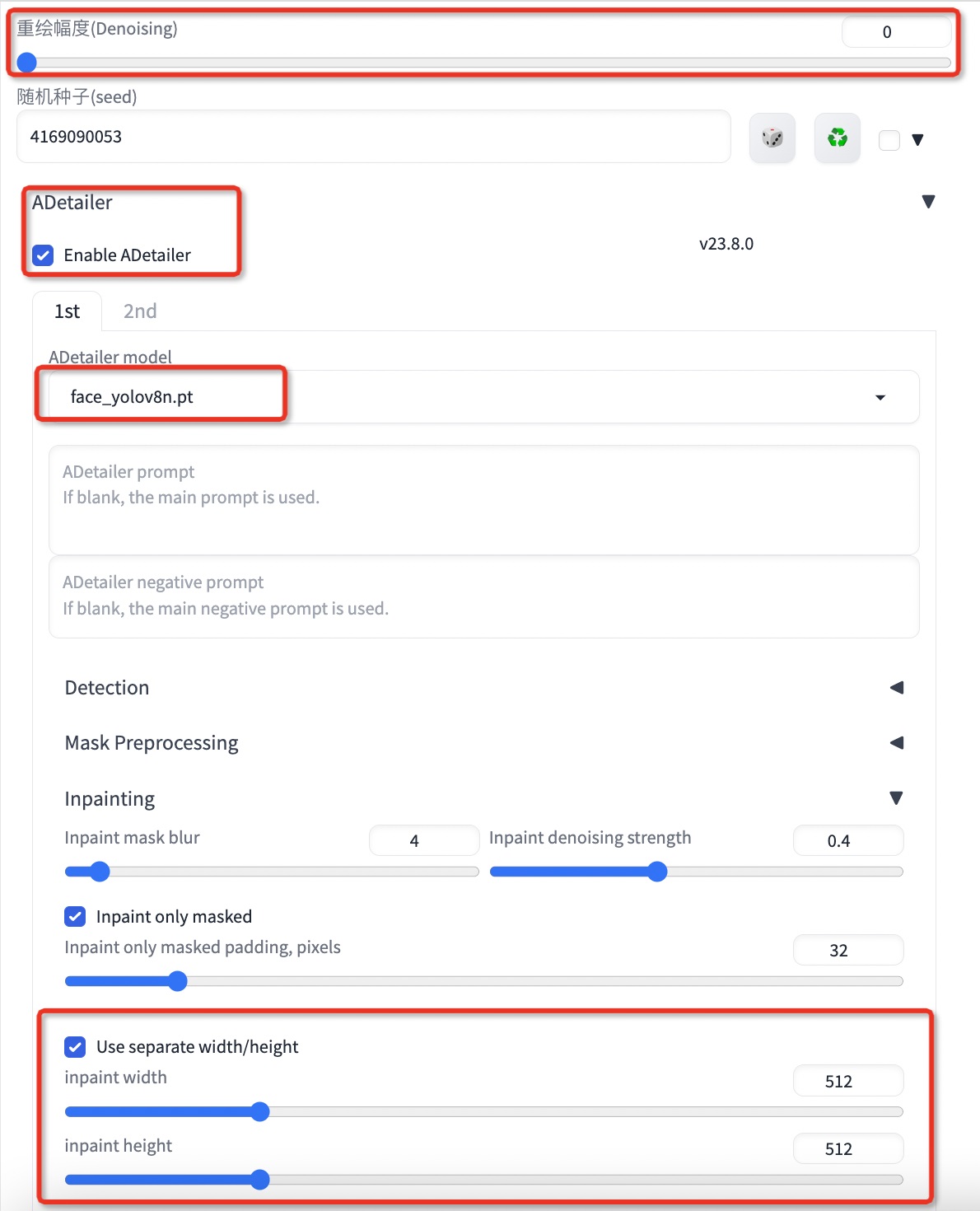

得到上图,效果相当不错,手部已经自然的融入环境,只剩下面部细节不丰富精致的问题 13. 最后一步——修脸,还是用修脸插件「ADtailer」 再次将生成的图「发送到图生图」,开启 SD 的修脸插件「ADtailer」选择脸部模型「face_yolov8s.pt」关键词不用写 重绘幅度设为 0,同时在重绘下开启「独立重绘宽高」如红框所示,目的是为了避免 2 次修脸,导致过度修脸

重绘幅度为 0——为了保证SD本身不做任何 重绘,脸部外的区域保持不变 「独立重绘宽高」——指「ADtailer」插件工作——在独立的宽高区域下重绘1次脸,再把生成的脸放到原图上,合在一起得到最终图 完成以上设置,再次「生成」跑图,得到下图

哇,是不是很美~~ 经过这步修脸之后,我们所有问题都处理完了,这次生成的图,有精致丰富的面部细节,自然的手部动作,以及准确的姿势,都保证了与原图的极大相似; 至此我们就完成了真人照片转二次元的所有流程,得到了我们的最终绝美照片,也完成了 1 对 1 的定制生成; 客官 怎么样, 这样的效果您还满意吗 快去拿着这份「宝典」用自己的照片试一试叭,二次元美女期待你的大波返图 ~ 上文提到的插件:

手机扫一扫,阅读下载更方便˃ʍ˂ |

@版权声明

1、本网站文章、帖子等仅代表作者本人的观点,与本站立场无关。

2、转载或引用本网版权所有之内容须注明“转自(或引自)网”字样,并标明本网网址。

3、本站所有图片和资源来源于用户上传和网络,仅用作展示,如有侵权请联系站长!QQ: 13671295。

最新评论