AIGC实战案例!如何10秒快速生成IP海报?

扫一扫

扫一扫

扫一扫

扫一扫

众所周知,各大厂目前都在 AIGC 的领域探索实践,也有非常多的外部设计师制作了大量的 AIGC 相关授课,很多同学因为不清楚具体能得到什么价值或者收获而停止了脚步。今天我来为大家分享一下经过实际探索且落地的 Stable diffusion 的 IP 海报生成流程,内容很干请上车坐稳。 更多AI实战案例: AIGC 大厂实战!微博商业化主视觉设计全流程这次文章来聊聊如何使用 AI 生图工具去辅助从 0 到 1 的主视觉项目。 阅读文章 >先来看一下达达骑士 IP 的效果: V1 模型生成

V2 模型生成

V3 模型生成

一、运用 SD 训练 IP 的流程和技巧(LoRA 篇)先来介绍一下什么是 LoRA。 大家刚接触 stable diffusion 时,会听到很多专业术语,其中 LoRA 模型必定是会被提及到的,那么什么是 LoRA 模型?它有什么作用呢? LoRA 模型全称是:Low-Rank Adaptation of Large Language Models,可以理解为 Stable-Diffusion 中的一个插件,仅需要少量的数据就可以进行训练的一种模型。在生成图片时,LoRA 模型会与大模型结合使用,从而实现对输出图片结果的调整。 举个例子:大模型好比没有修饰过的人物、物品、场景、等;LoRA 模型好比是改变人物、物品、场景等内容的形色质构的因素,但仍然在大模型的底子下。当然 LoRA 模型不仅仅限制于人物,场景、动漫、风格。 1. 训练环境的搭建 本地:可下载秋葉 SD trainer 训练器一键包,具体教程看: 保姆级教程!手把手教你 Mac 本地部署 Stable-Diffusion此文详细介绍了 Stable-Diffusion 的部署过程,希望对大家有所帮助。 阅读文章 >2. 训练集处理(图片处理+打标+训练参数) ①图片处理 首先我们需要准备训练的 IP(也可以是:物品、场景、风格等),训练图的尺寸需要统一,且以 64 的倍数设置:常用分辨率为 512*512、512*768、768*1152。因为如果尺寸不统一或不是 64 的倍数,AI 在训练过程会对你的图片进行裁切,导致你想要的画面细节被裁减 其次我们需要有 3 种类型的图:白底 IP 图+场景 IP 结合图+单独场景图,整个训练集的数量可以有多少准备多少,越多越好(但是要保证差异性,重复的动作或角度需要剔除)。

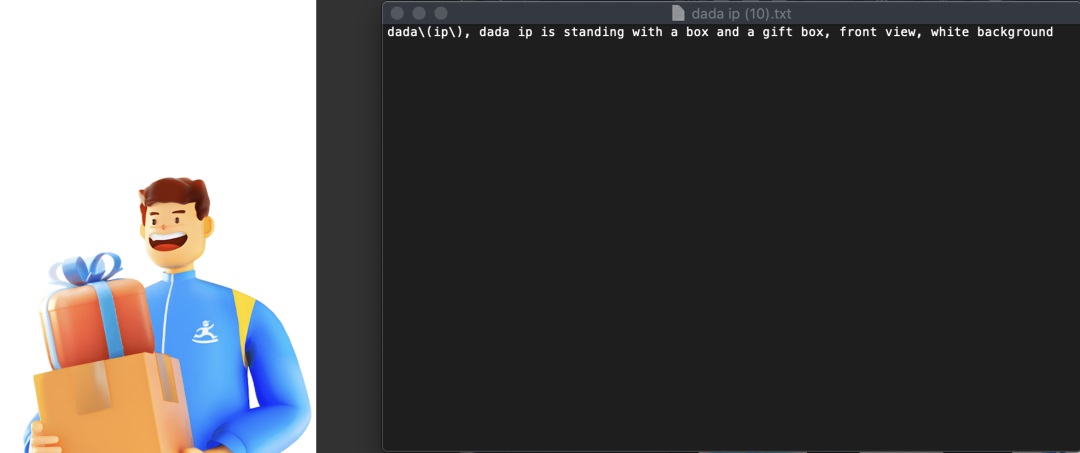

②打标 当我们准备好需要 AI 训练的图以后我们需要对这些训练图进行描述,可使用自动打标工具或手动打标(手动打标训练效果会更好) ,准备一个 txt 文本(保证和你描述的图片命名一一对应),然后进行详细的描述,以下是我的一些举例: 在打标描述里需要注意格式:我们常用的格式是“触发词”+“自然语言”+“单词”,并且保证全程英文输入,包括标点符号

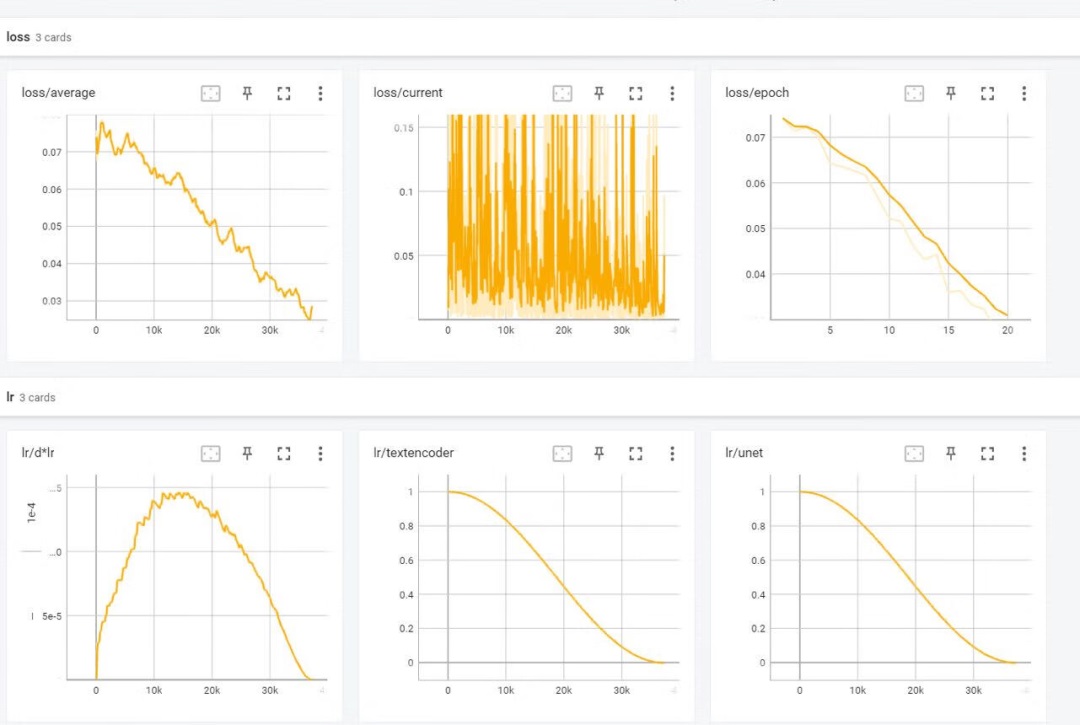

3. 模型训练&参数设置 (注:这里的参数需要根据自身训练的 IP 或内容进行调优,存在是错成本,这里给大家科普一些基础) ①补充 2 个概念:欠拟合、过拟合 过拟合:指 AI 只会生成你给他提供的训练集内容,比如 IP 动作、场景、元素、等 欠拟合:指 AI 生成的内容和你训练集的内容完全没关联,或者说收敛性很差导致 IP 不像 ②基础训练参数 repeat 次数(每张图训练的次数,次数不是越高越高,训练太多会导致过拟合,训练太少会导致欠拟合) epoch 训练轮数(训练集训练的轮数,轮数不是越高越好,训练太多会导致过拟合,训练太少会导致欠拟合) dim 值(dim 代表了训练的精度) alpha 值(alpha 用于控制模型复杂性和约束性,alpha 必须≤dim) learning rate、unet lr、text encoder lr(学习率决定模型学习的程度,影响训练效果,比如稳定性、泛化性、收敛性) 训练优化器(自适应优化器和非自适应,决定了 AI 学习节奏) ③训练过程中的观察 需要观察训练的 Loss 值,Loss 值需要成递减状态(正常状态),曲线波动不易较大。并且需要记录每一次训练的参数和 Loss 值来分析后续模型调优的方向

4. 模型测试 模型测试阶段,我们需要启动 SD,并且运用 XYZ 轴来测试每个版本的模型搭配的 LoRA 权重,以及大模型,最终沉淀出我们最优版本的模型。 在测试阶段我们需要围绕着 3 个核心的点:稳定性、泛化性、以及收敛性进行测试。 稳定性:模型是不是在大多数 prompt 输入下,都能够出现好的效果 泛化行:生成的内容是不是有 AI 创新的内容(动作、场景、元素、等) 收敛性:生成的 IP 以及特征(或其他核心内容)是不是你想要的效果

五、运用 SD 稳定生成高质量 IP 海报

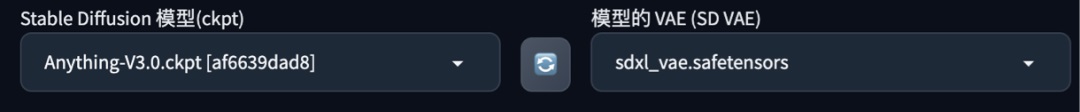

1. 模型&提示词 生成环境模型主要包括 3 类,底模、LoRA 模型、以及 VAE(可以理解为滤镜),我们可以尝试各种不同的大模型,比如二次元的 anything、目前用的最多的 Rev、或者真人类的 real。 提示词分为 2 部分,正向词为你想要的内容,负向词代表你不想要的内容 正向词:会出现 3 种类型:触发词+提示词+LoRA,越靠前的词汇权重就会越高 在生成出好的效果后大家可以对自己的 prompt 进行保存:

2. 采样方式 简单来说,这些采样器是算法,它们在每个步骤后获取生成的图像并将其与文本提示请求的内容进行比较,然后对噪声进行一些更改,直到它逐渐达到与文本描述匹配的图像 常用的采样器如:Euler a、DDIM、DPM++系列,可以根据自己模型来调整尝试出最好的参数 3. 采样迭代步数 SD 通过从充满噪点的画布开始创建图像,然后逐渐去噪以达到最终输出。Steps 就是控制这些去噪步骤的数量。通常,越高越好,但一般情况下,我们使用的默认值是 20 个步骤,这其实已经足以生成任何类型的图像 如果在测试新提示希望快速得到理想的构图或结果,可使用 15-20steps 当找到确认的 seed 后,可将步骤增加到 20-30steps 4. 面部修复 面部修复可改善脸部特这个以及细节,让人脸更自然和美观,建议当找到确认的 seed 后打开 5. 高清修复 通过使用算法,AI 可以首先在较低的分辨率下对图片进行部分渲染,然后将其提升到高分辨率,并在高分辨率下添加细节,建议当找到确认的 seed 后打开。 常用高清算法如:R-ESRGAN 4x++ 6. 重绘幅度 可以理解为 AI 在创作过程中的发散幅度,越高的值会带来越大的创意,反之会更精准。

7. 随机种子 Seed 可以理解为你生成图的身份 ID,每个生成图都有自己的 seed,当确认了基础构图以及想要的基础效果后锁定种子,从而完成微调

8. 尺寸、批次、批数 尺寸:一般会以 64 的倍数去递增,常用尺寸在前期确认 seed 之前会用到 512*768,512*512,等 生成批次、每批数量:每批、每次次生成的图像数量,建议在前期找画面之前可以开大数量去抽卡,找到自己想要的画面,然后锁定 seed

9. 点击生成,完成 IP 海报(记得记住&保存自己的参数模版) 到这里我们整个流程就走完了,接下来我们就可以不断的生成和创新我们的 IP 海报了 欢迎关注「京东设计中心JDC」的微信公众号:

手机扫一扫,阅读下载更方便˃ʍ˂ |

@版权声明

1、本网站文章、帖子等仅代表作者本人的观点,与本站立场无关。

2、转载或引用本网版权所有之内容须注明“转自(或引自)网”字样,并标明本网网址。

3、本站所有图片和资源来源于用户上传和网络,仅用作展示,如有侵权请联系站长!QQ: 13671295。

最新评论